Linux環境:CentOs6.4

Hadoop版本:Hadoop-1.1.2

master: 192.168.1.241 NameNode JobTracker DataNode TaskTracker

slave:192.168.1.242 DataNode TaskTracker

內容:想hadoop文件系統中上傳一個大文件,驗證文件分別分布在192.168.1.241節點和192.168.1.242節點上。

第一步: 前期工作:搭建Hadoop集群,

在hdfs-site.xml中的配置為2.

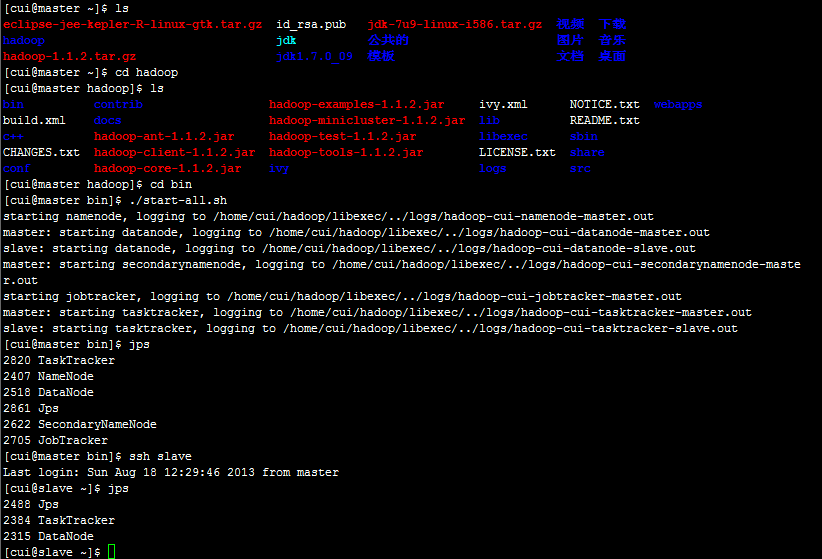

運行執行start-all.sh命令,運行結果如圖所示:

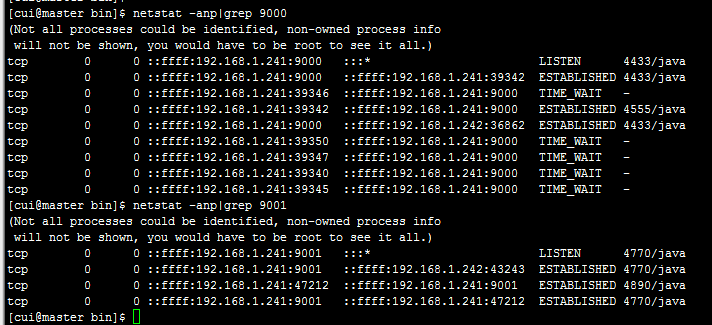

查看9000和9001的信息

9000是HDFS的入口9001是MapReduce的JobTracker的入口

從以上圖中可以確定Ip地址為192.168.1.241.

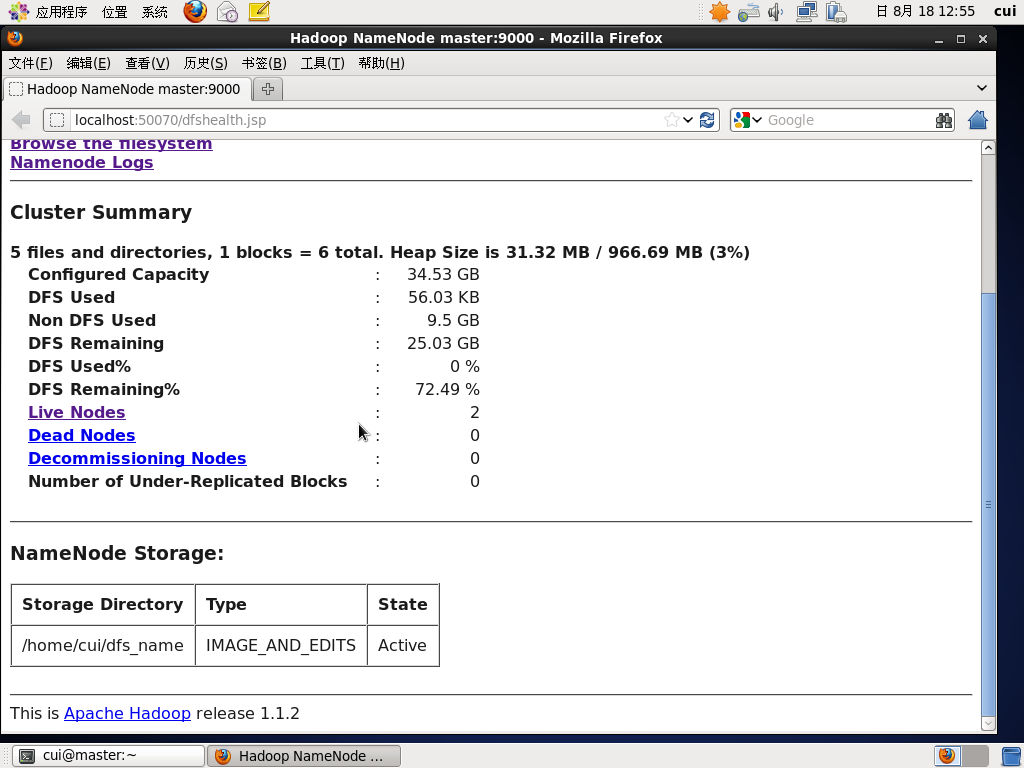

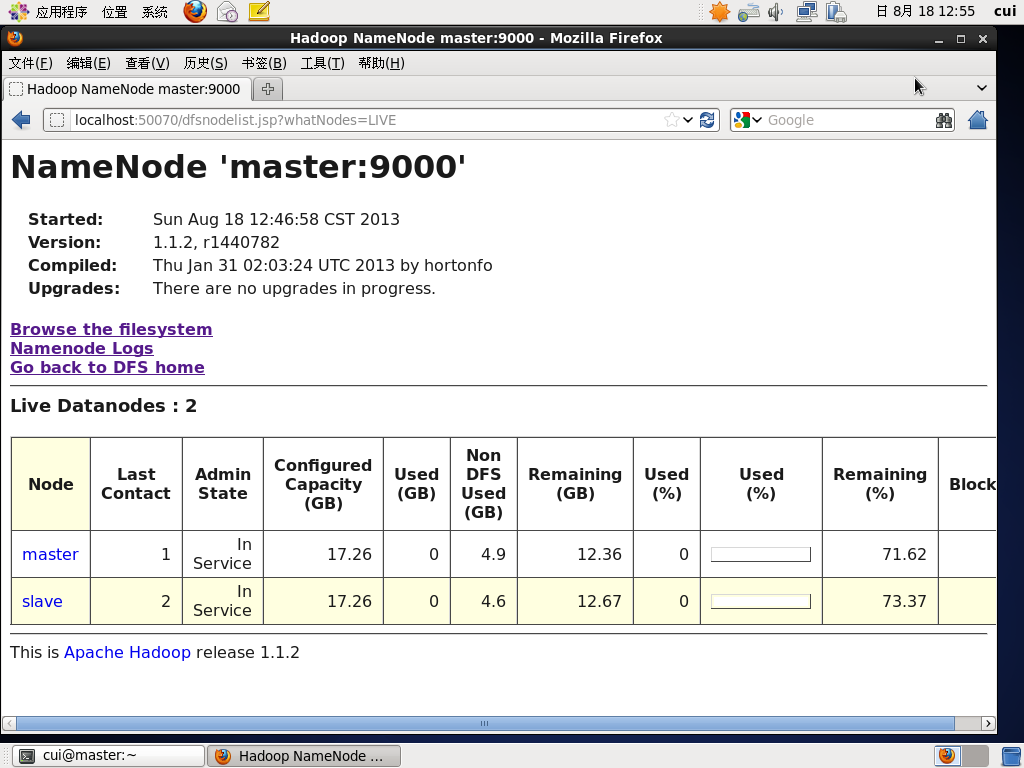

第二步:通過網頁查看節點的個數。在瀏覽器中輸入http://localhost:50070

以上看到LiveNodes的個數為2,說明啟動成功。

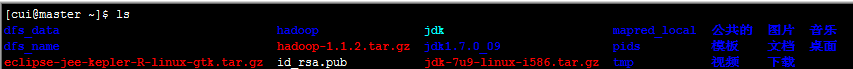

第三步:上傳大文件。具體步驟如圖所示:

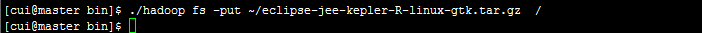

通過網頁查看運行狀況:

大文件已經上傳成功.文件的大小是244.91MBlock的大小是64M。所以每個節點能夠有4個Block。

Replication為2,表明每個Block有2個備份。

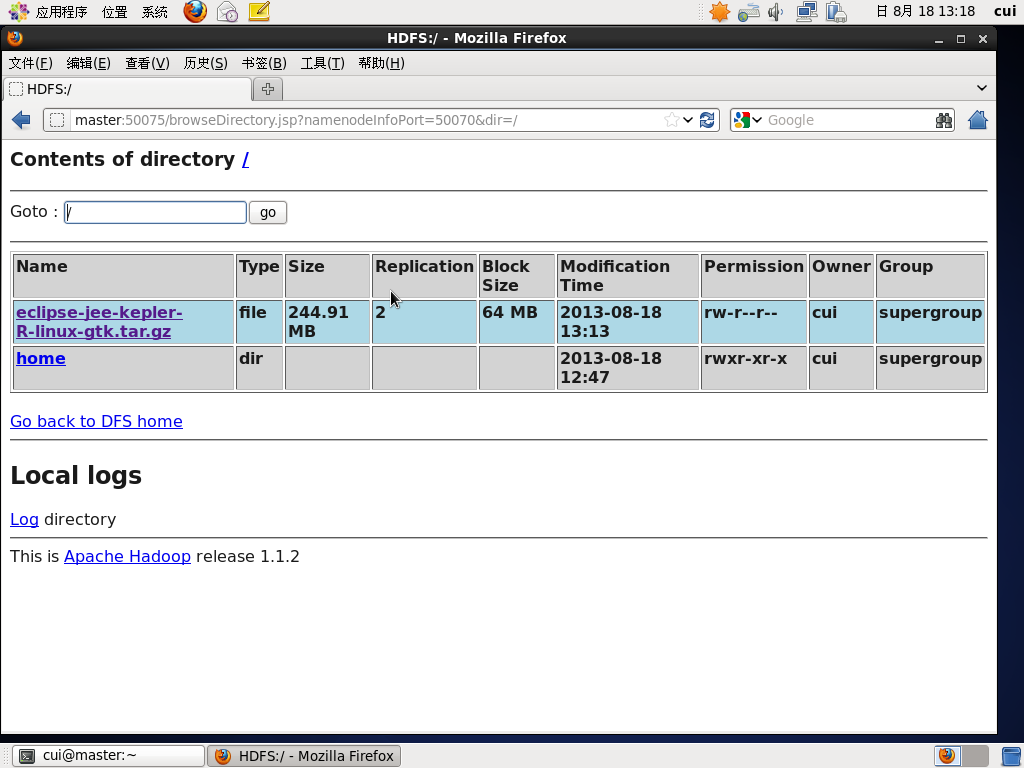

查看節點的使用情況:

從圖中可以看出,此文件分成了4個Block。(TotalNumberofblocks:4)。

每個Block在兩個節點上進行了備份,分別是192.168.1.241192.168.1.242

hadoop集群至此測試結束。測試成功。

新聞熱點

疑難解答

圖片精選