mechanize是對urllib2的部分功能的替換,能夠更好的模擬瀏覽器行為,在web訪問控制方面做得更全面。結(jié)合beautifulsoup和re模塊,可以有效的解析web頁面,我比較喜歡這種方法。

下面主要總結(jié)了使用mechanize模擬瀏覽器的行為和幾個例子(谷歌搜索,百度搜索和人人網(wǎng)登錄等)

1.初始化并建立一個瀏覽器對象

如果沒有mechanize需要easy_install安裝,以下代碼建立瀏覽器對象并作了一些初始化設置,實際使用過程可以按需開關。其實只用默認的設置也可以完成基本任務。

#!/usr/bin/env pythonimport sys,mechanize#Browserbr = mechanize.Browser()#optionsbr.set_handle_equiv(True)br.set_handle_gzip(True)br.set_handle_redirect(True)br.set_handle_referer(True)br.set_handle_robots(False)#Follows refresh 0 but not hangs on refresh > 0br.set_handle_refresh(mechanize._http.HTTPRefreshProcessor(), max_time=1)#debugging?br.set_debug_http(True)br.set_debug_redirects(True)br.set_debug_responses(True)#User-Agent (this is cheating, ok?)br.addheaders = [('User-agent', 'Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.1) Gecko/2008071615 Fedora/3.0.1-1.fc9 Firefox/3.0.1')]

2.模擬瀏覽器行為

瀏覽器對象建立并初始化完畢之后即可使用了,下面給出幾個例子(代碼承接以上部分)

獲取web網(wǎng)頁:

分行打印可以逐個查看詳細信息,就不贅述

r = br.open(sys.argv[1])html = r.read()print htmlprint br.response().read()print br.title()print r.info()

模擬谷歌和百度查詢

打印和選擇forms,然后填寫相應鍵值,通過post提交完成操作

for f in br.forms(): print fbr.select_form(nr=0)

谷歌查詢football

br.form['q'] = 'football'br.submit()print br.response().read()

百度查詢football

br.form['wd'] = 'football'br.submit()print br.response().read()

相應鍵值名,可以通過打印查出

回退(Back)

非常簡單的操作,打印url即可驗證是否回退

# Backbr.back()print br.geturl()

3.http基本認證

4.form認證

以登陸人人網(wǎng)為例,打印forms可以查出用戶名和密碼鍵信息

br.select_form(nr = 0)br['email'] = usernamebr['password'] = passwordresp = self.br.submit()

5.cookie支持

通過導入cookielib模塊,并設置瀏覽器cookie,可以在需要認證的網(wǎng)絡行為之后不用重復認證登陸。通過保存session cookie即可重新訪問,Cookie Jar完成了該功能。

#!/usr/bin/env pythonimport mechanize, cookielibbr = mechanize.Browser()cj = cookielib.LWPCookieJar()br.set_cookiejar()

6.proxy設置

設置http代理

#Proxybr.set_proxies({"http":"proxy.com:8888"})br.add_proxy_password("username", "password")#Proxy and usrer/passwordbr.set_proxies({"http":"username:password@proxy.com:8888"})

7.關于內(nèi)存過高問題

在用mechanize寫了一個爬蟲腳本,想要去某網(wǎng)站爬取大概30萬張圖片。

整個過程是:

1、獲取目標頁面地址

2、取得目標地址前幾頁的所有圖片url

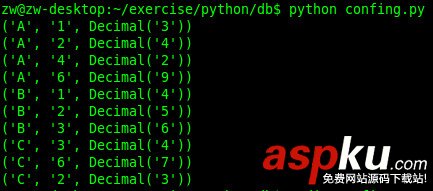

3、對這些url進行下載,并把索引數(shù)據(jù)保存到mysql數(shù)據(jù)庫。

這個腳本大概每秒鐘完成一張圖片的下載(主要是網(wǎng)絡只有200K/S左右,是瓶頸)

當圖片下載到大約15000張左右的時候,發(fā)現(xiàn)越來越慢,最后干脆停下了。

用ps aux查看,發(fā)現(xiàn)進程sleep了,感覺很奇怪。

free看一下,內(nèi)存竟然只剩下100M了(系統(tǒng)總內(nèi)存4GB)

在網(wǎng)上瞎逛了一下,發(fā)現(xiàn)原來mechanize默認會保存模擬過的操作歷史,導致占用的內(nèi)存越來越大:

http://stackoverflow.com/questions/2393299/how-do-i-disable-history-in-python-mechanize-module

為了方便,大約翻譯一下:

mechanize初始化Browser()的時候,如果你不給他傳一個history對象作為參數(shù),Browser()就會按照默認的方式(允許保存操作歷史)來進行初始化,你可以隨便傳個什么history給它即可,如自定義一個NoHistory對象:

class NoHistory(object): def add(self, *a, **k): pass def clear(self): pass b = mechanize.Browser(history=NoHistory())