正則表達式的使用

想要學習 Python 爬蟲 , 首先需要了解一下正則表達式的使用,下面我們就來看看如何使用。

. 的使用這個時候的點就相當于一個占位符,可以匹配任意一個字符,什么意思呢?看個例子就知道

import re content = "helloworld" b = re.findall('w.',content) print b`注意了,我們首先導入了 re,這個時候大家猜一下輸出結(jié)果是什么?因為 . 相當于一個占位符,所以理所當然的這個時候的輸出結(jié)果是 wo 。

* 的使用跟上面的 . 不同,* 可以匹配前一個字符任意次數(shù),看個例子

content = "helloworldhelloworld" b = re.findall('w*',content) print b這個時候的輸出結(jié)果是 ['', '', '', '', '', 'w', '', '', '', '', '', '', '', '', '', 'w', '', '', '', '', ''],可見是一個列表,長度和匹配的字符串一致,遇到要匹配的字符就打印出來。

.* 的使用.* 是一種組合使用,它可以盡可能多的匹配內(nèi)容,比如下面這個例子

content = "helloworldhelloworldworld" b = re.findall('he.*ld',content) print b它會輸出 ['helloworldhelloworldworld'],它為什么不只打印一個 helloworld,為什么全部打印下來了?這就是一種貪心算法,也就是說我要找到最長的那個符合條件的內(nèi)容。

.*? 的使用與 上面相反,這個符號會找到盡可能短的符合條件的內(nèi)容,然后放到一個列表中去,如下所示

content = 'xxhelloworldxxxxhelloworldxx' b = re.findall('xx.*?xx',content) print b輸出的結(jié)果為 ['xxhelloworldxx', 'xxhelloworldxx'],可見,有個 xx 在前面好煩,怎么才能去掉呢?很簡單,加個括號即可,括號加在哪?

content = 'xxhelloworldxxxxhelloworldxx' b = re.findall('xx(.*?)xx',content) print b以上我們討論的都是內(nèi)容不包含換行符的情況,如果有了換行符結(jié)果又會發(fā)生什么變化呢?

content = '''xxhelloworld xx''' b = re.findall('xx(.*?)xx',content) print b這個時候的輸出結(jié)果為一個空列表,那怎么辦啊?如果我們寫網(wǎng)絡(luò)爬蟲的時候,網(wǎng)頁源代碼肯定不止是一行啊,如果換一行我們就讀不出來了,那就好尷尬了,當然有解決辦法~

content = '''xxhelloworld xx''' b = re.findall('xx(.*?)xx',content,re.S) print b這樣就可以了,還有一個非常方便的提取數(shù)字的技巧,如下所示

content = '''xx123456 xx''' b = re.findall('(d+)',content,re.S) print b在網(wǎng)頁源代碼中爬取圖片鏈接并下載

這篇文章中只是網(wǎng)絡(luò)爬蟲的第一步,所以講解的也比較淺,所以現(xiàn)在我們先來利用正則表達式實現(xiàn)一個手動的網(wǎng)絡(luò)爬蟲,什么是手動的呢?就是我們自己把網(wǎng)頁源代碼復制下來,保存在一個 txt 文件中,然后利用正則表達式去過濾信息,然后去下載。

首先我搜索了一下 Linux 桌面,然后找到了如下一個網(wǎng)頁

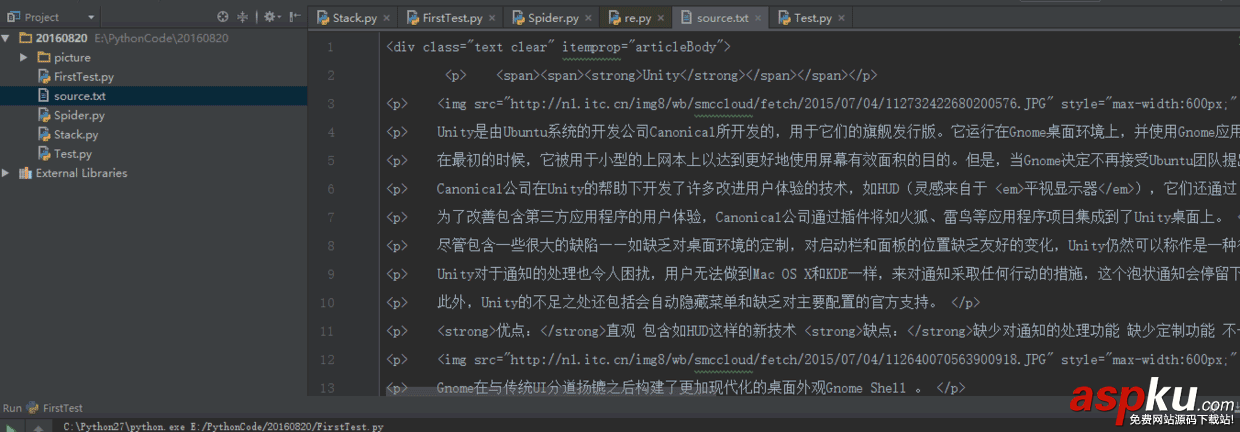

右擊查看網(wǎng)絡(luò)源代碼,按 ctrl+f 搜索 img src 找到中間一部分進行復制,并且粘貼到一個 txt 文件中去,

然后就可以利用我們上述的知識去提取我們想要的信息,源代碼如下

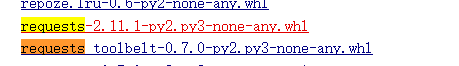

import re import requests f = open('source.txt', 'r') html = f.read() f.close() pattern = '<img src="(.*?)"' pic_url = re.findall(pattern, html, re.S) i = 0 for each in pic_url: print 'Downloading :' + each pic = requests.get(each) fp = open('picture//' + str(i) + '.jpg', 'wb') fp.write(pic.content) fp.close() i = i + 1首先打開我們保存網(wǎng)絡(luò)源代碼的 txt文件,進行讀取,關(guān)閉文件流,然后就是利用正則表達式提取圖片鏈接,最后利用requests 中的 get() 方法進行圖片下載,注意這個 requests 不是Python 中自帶的,我們需要下載指定的文件,然后將其放入到 Python 的Lib 目錄下,此處下載,進入網(wǎng)站后,按ctrl+f 搜索關(guān)鍵詞 requests 就可以看到如下頁面

,可以看出,我們下載的是 .whl 后綴的文件,手動將其改成 .zip 后綴,然后解壓,就可以得到兩個目錄,將名為 requests 的目錄復制粘貼到上面講的目錄即可使用。

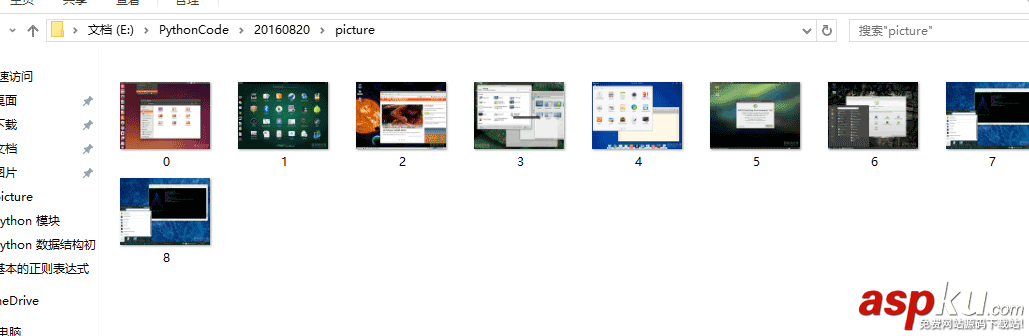

好了介紹完了,我們?nèi)タ聪逻\行結(jié)果

C:Python27python.exe E:/PythonCode/20160820/Spider.py Downloading:http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112732422680200576.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112640070563900918.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112547718465744154.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112455366330382227.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112363014254719641.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112270662197888742.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112178310031994750.JPG Downloading :http://n1.itc.cn/img8/wb/smccloud/fetch/2015/07/04/112085957910403853.JPG Process finished with exit code 0

這個時候就下載成功了,到我們的 picture 目錄下去查看下載的圖片

下載成功了。注意,自己找網(wǎng)頁源代碼實驗的時候,最好不要讓鏈接中帶有中文,否則可能會出現(xiàn)亂碼,由于我本身學習 Python 也才很短的時間,關(guān)于中文亂碼問題,應(yīng)對起來還不是那么得心應(yīng)手,所以在此也就不再講解,本文暫時告以段落,有意見或疑問可留言或者私聊我。

新聞熱點

疑難解答

圖片精選