在我們?nèi)粘I暇W(wǎng)瀏覽網(wǎng)頁的時(shí)候,經(jīng)常會(huì)看到一些好看的圖片,我們就希望把這些圖片保存下載,或者用戶用來做桌面壁紙,或者用來做設(shè)計(jì)的素材。

我們最常規(guī)的做法就是通過鼠標(biāo)右鍵,選擇另存為。但有些圖片鼠標(biāo)右鍵的時(shí)候并沒有另存為選項(xiàng),還有辦法就通過就是通過截圖工具截取下來,但這樣就降低圖片的清晰度。好吧~!其實(shí)你很厲害的,右鍵查看頁面源代碼。

我們可以通過python 來實(shí)現(xiàn)這樣一個(gè)簡(jiǎn)單的爬蟲功能,把我們想要的代碼爬取到本地。下面就看看如何使用python來實(shí)現(xiàn)這樣一個(gè)功能。

一,獲取整個(gè)頁面數(shù)據(jù)

首先我們可以先獲取要下載圖片的整個(gè)頁面信息。

getjpg.py

#coding=utf-8import urllibdef getHtml(url): page = urllib.urlopen(url) html = page.read() return htmlhtml = getHtml("http://tieba.baidu.com/p/2738151262")print htmlUrllib 模塊提供了讀取web頁面數(shù)據(jù)的接口,我們可以像讀取本地文件一樣讀取www和ftp上的數(shù)據(jù)。首先,我們定義了一個(gè)getHtml()函數(shù):

urllib.urlopen()方法用于打開一個(gè)URL地址。

read()方法用于讀取URL上的數(shù)據(jù),向getHtml()函數(shù)傳遞一個(gè)網(wǎng)址,并把整個(gè)頁面下載下來。執(zhí)行程序就會(huì)把整個(gè)網(wǎng)頁打印輸出。

二,篩選頁面中想要的數(shù)據(jù)

Python 提供了非常強(qiáng)大的正則表達(dá)式,我們需要先要了解一點(diǎn)python 正則表達(dá)式的知識(shí)才行.

假如我們百度貼吧找到了幾張漂亮的壁紙,通過到前段查看工具。找到了圖片的地址,如:src=”http://imgsrc.baidu.com/forum......jpg”pic_ext=”jpeg”

修改代碼如下:

import reimport urllibdef getHtml(url): page = urllib.urlopen(url) html = page.read() return htmldef getImg(html): reg = r'src="(.+?/.jpg)" pic_ext' imgre = re.compile(reg) imglist = re.findall(imgre,html) return imglist html = getHtml("http://tieba.baidu.com/p/2460150866")print getImg(html)我們又創(chuàng)建了getImg()函數(shù),用于在獲取的整個(gè)頁面中篩選需要的圖片連接。re模塊主要包含了正則表達(dá)式:

re.compile() 可以把正則表達(dá)式編譯成一個(gè)正則表達(dá)式對(duì)象.

re.findall() 方法讀取html 中包含 imgre(正則表達(dá)式)的數(shù)據(jù)。

運(yùn)行腳本將得到整個(gè)頁面中包含圖片的URL地址。

三,將頁面篩選的數(shù)據(jù)保存到本地

把篩選的圖片地址通過for循環(huán)遍歷并保存到本地,代碼如下:

#coding=utf-8import urllibimport redef getHtml(url): page = urllib.urlopen(url) html = page.read() return htmldef getImg(html): reg = r'src="(.+?/.jpg)" pic_ext' imgre = re.compile(reg) imglist = re.findall(imgre,html) x = 0 for imgurl in imglist: urllib.urlretrieve(imgurl,'%s.jpg' % x) x+=1html = getHtml("http://tieba.baidu.com/p/2460150866")print getImg(html)這里的核心是用到了urllib.urlretrieve()方法,直接將遠(yuǎn)程數(shù)據(jù)下載到本地。

通過一個(gè)for循環(huán)對(duì)獲取的圖片連接進(jìn)行遍歷,為了使圖片的文件名看上去更規(guī)范,對(duì)其進(jìn)行重命名,命名規(guī)則通過x變量加1。保存的位置默認(rèn)為程序的存放目錄。

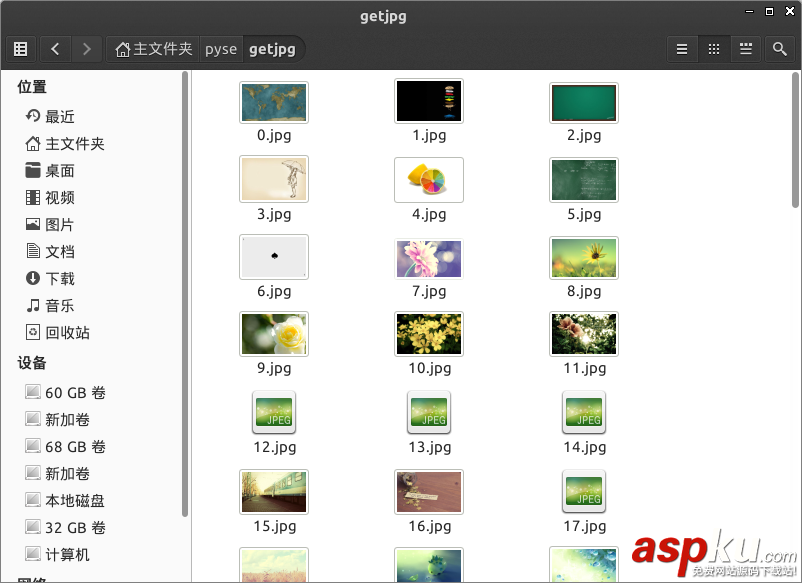

程序運(yùn)行完成,將在目錄下看到下載到本地的文件。

感謝閱讀,希望能幫助到大家,謝謝大家對(duì)本站的支持!

新聞熱點(diǎn)

疑難解答

圖片精選