本文介紹了Python3網絡爬蟲之使用User Agent和代理IP隱藏身份,分享給大家,具體如下:

一、為何要設置User Agent

有一些網站不喜歡被爬蟲程序訪問,所以會檢測連接對象,如果是爬蟲程序,也就是非人點擊訪問,它就會不讓你繼續訪問,所以為了要讓程序可以正常運行,需要隱藏自己的爬蟲程序的身份。此時,我們就可以通過設置User Agent的來達到隱藏身份的目的,User Agent的中文名為用戶代理,簡稱UA。

User Agent存放于Headers中,服務器就是通過查看Headers中的User Agent來判斷是誰在訪問。在Python中,如果不設置User Agent,程序將使用默認的參數,那么這個User Agent就會有Python的字樣,如果服務器檢查User Agent,那么沒有設置User Agent的Python程序將無法正常訪問網站。

Python允許我們修改這個User Agent來模擬瀏覽器訪問,它的強大毋庸置疑。

二、常見的User Agent

1.Android

2.Firefox

3.Google Chrome

4.iOS

上面列舉了Andriod、Firefox、Google Chrome、iOS的一些User Agent,直接copy就能用。

三、設置User Agent的方法

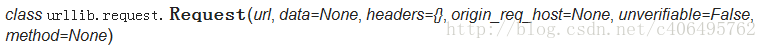

先看下urllib.request.Request()

從上圖可以看出,在創建Request對象的時候,可以傳入headers參數。

因此,想要設置User Agent,有兩種方法:

1.在創建Request對象的時候,填入headers參數(包含User Agent信息),這個Headers參數要求為字典;

2.在創建Request對象的時候不添加headers參數,在創建完成之后,使用add_header()的方法,添加headers。

方法一:

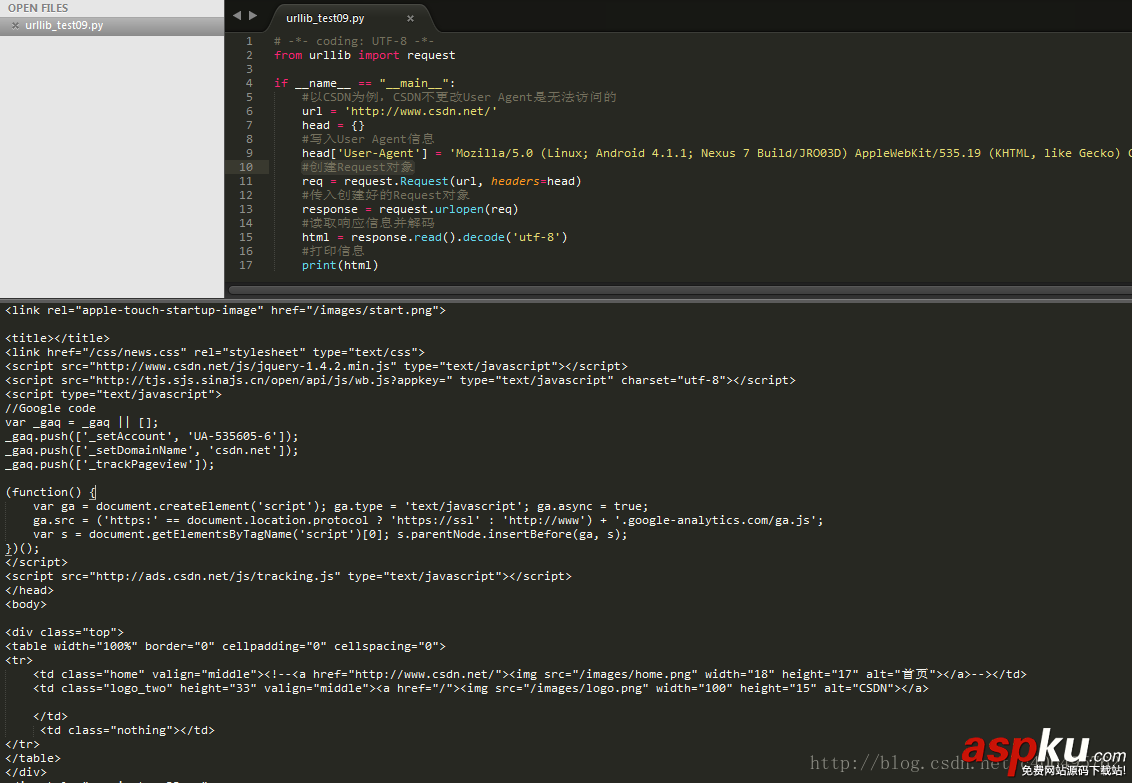

創建文件urllib_test09.py,使用上面提到的Android的第一個User Agent,在創建Request對象的時候傳入headers參數,編寫代碼如下:

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__": #以CSDN為例,CSDN不更改User Agent是無法訪問的 url = 'http://www.csdn.net/' head = {} #寫入User Agent信息 head['User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19' #創建Request對象 req = request.Request(url, headers=head) #傳入創建好的Request對象 response = request.urlopen(req) #讀取響應信息并解碼 html = response.read().decode('utf-8') #打印信息 print(html)運行結果如下:

方法二:

創建文件urllib_test10.py,使用上面提到的Android的第一個User Agent,在創建Request對象時不傳入headers參數,創建之后使用add_header()方法,添加headers,編寫代碼如下:

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__": #以CSDN為例,CSDN不更改User Agent是無法訪問的 url = 'http://www.csdn.net/' #創建Request對象 req = request.Request(url) #傳入headers req.add_header('User-Agent', 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19') #傳入創建好的Request對象 response = request.urlopen(req) #讀取響應信息并解碼 html = response.read().decode('utf-8') #打印信息 print(html)運行結果和上一個方法是一樣的。

四、IP代理的使用

1.為何使用IP代理

User Agent已經設置好了,但是還應該考慮一個問題,程序的運行速度是很快的,如果我們利用一個爬蟲程序在網站爬取東西,一個固定IP的訪問頻率就會很高,這不符合人為操作的標準,因為人操作不可能在幾ms內,進行如此頻繁的訪問。所以一些網站會設置一個IP訪問頻率的閾值,如果一個IP訪問頻率超過這個閾值,說明這個不是人在訪問,而是一個爬蟲程序。

2.一般步驟說明

一個很簡單的解決辦法就是設置延時,但是這顯然不符合爬蟲快速爬取信息的目的,所以另一種更好的方法就是使用IP代理。使用代理的步驟:

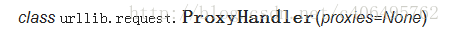

(1)調用urlib.request.ProxyHandler(),proxies參數為一個字典。

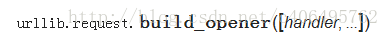

(2)創建Opener(類似于urlopen,這個代開方式是我們自己定制的)

(3)安裝Opener

使用install_opener方法之后,會將程序默認的urlopen方法替換掉。也就是說,如果使用install_opener之后,在該文件中,再次調用urlopen會使用自己創建好的opener。如果不想替換掉,只是想臨時使用一下,可以使用opener.open(url),這樣就不會對程序默認的urlopen有影響。

3.代理IP選取

在寫代碼之前,先在代理IP網站選好一個IP地址,推薦西刺代理IP。

URL:http://www.xicidaili.com/

注意:當然也可以寫個正則表達式從網站直接爬取IP,但是要記住不要太頻繁爬取,加個延時什么的,太頻繁給服務器帶來壓力了,服務器會直接把你block,不讓你訪問的,我就被封了兩天。

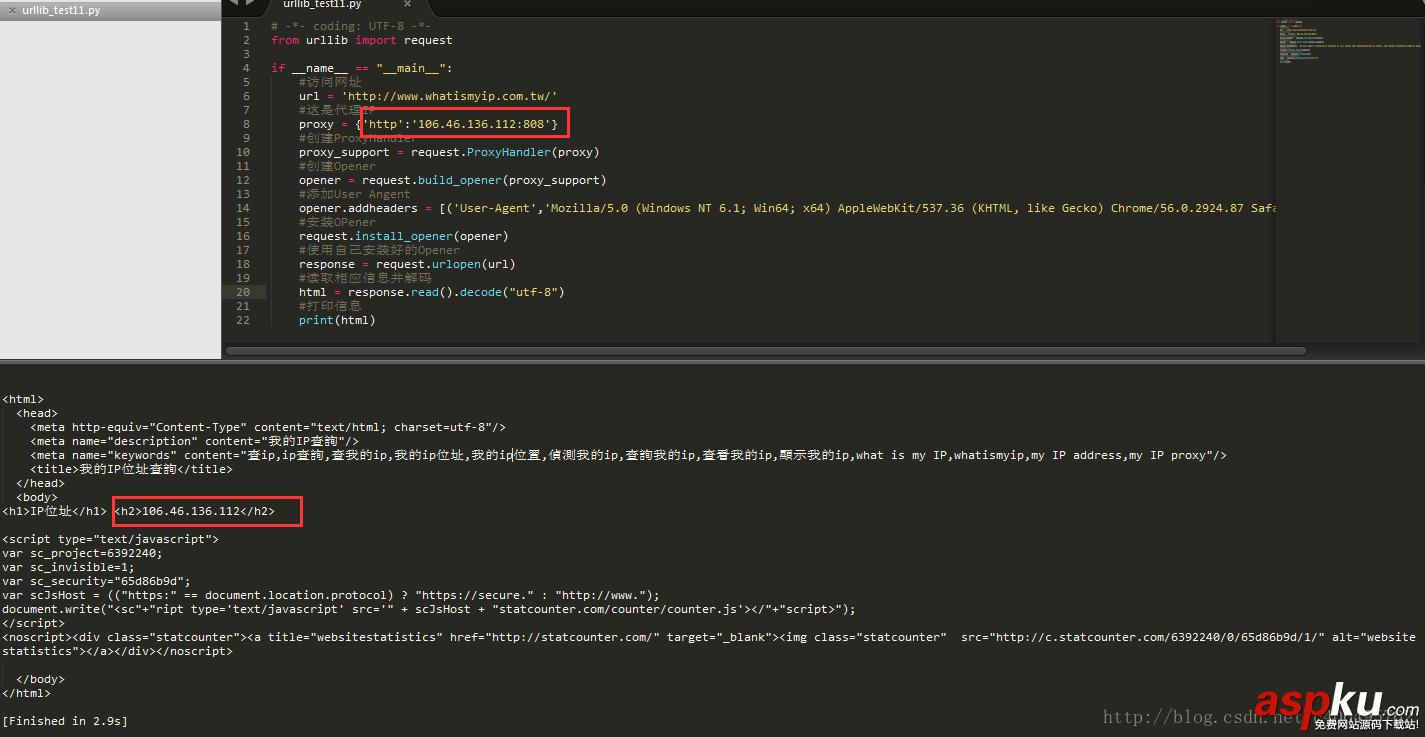

從西刺網站選出信號好的IP,我的選擇如下:(106.46.136.112:808)

編寫代碼訪問http://www.whatismyip.com.tw/,該網站是測試自己IP為多少的網址,服務器會返回訪問者的IP。

4.代碼實例

創建文件urllib_test11.py,編寫代碼如下:

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__": #訪問網址 url = 'http://www.whatismyip.com.tw/' #這是代理IP proxy = {'http':'106.46.136.112:808'} #創建ProxyHandler proxy_support = request.ProxyHandler(proxy) #創建Opener opener = request.build_opener(proxy_support) #添加User Angent opener.addheaders = [('User-Agent','Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36')] #安裝OPener request.install_opener(opener) #使用自己安裝好的Opener response = request.urlopen(url) #讀取相應信息并解碼 html = response.read().decode("utf-8") #打印信息 print(html)運行結果如下:

從上圖可以看出,訪問的IP已經偽裝成了106.46.136.112。

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持VEVB武林網。

新聞熱點

疑難解答