前面已經(jīng)介紹過如何創(chuàng)建scrapy的項(xiàng)目,和對項(xiàng)目中的文件功能的基本介紹。

這次,就來談?wù)勈褂玫幕玖鞒蹋?/p>

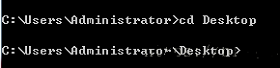

(1)首先第一點(diǎn),打開終端,找到自己想要把scrapy工程創(chuàng)建的路徑。這里,我是建立在桌面上的。打開終端,輸入:

cd Desktop 就進(jìn)入了桌面文件存儲位置。

(2)創(chuàng)建scrapy工程。終端輸入:scrapy startproject image

終端輸入:cd image

繼續(xù)輸入:scrapy genspider imageSpider pic.netbian.com

(3)在pycharm中打開剛才桌面的文件,進(jìn)入settings.py設(shè)置爬蟲規(guī)則。可以將規(guī)則直接注釋掉,或者改為False。

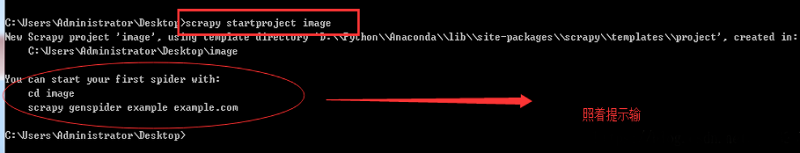

(4) 回到爬蟲文件。

更改start_url,將爬蟲默認(rèn)的第一個網(wǎng)址更改為需要爬取的網(wǎng)站網(wǎng)址即可。

(5)下面就可以爬取數(shù)據(jù)了,這里選擇了下載圖片。

爬取完數(shù)據(jù)之后,要在存儲數(shù)據(jù)的items.py文件中傳輸給管道

接下來在爬蟲文件中引入管道模型。

from ..items import ImageItem

在爬蟲文件中的parse函數(shù)中使用在items.py文件中創(chuàng)建的數(shù)據(jù)模型。

item = ImageItem()

注意點(diǎn):

有時候在終端輸出的時候,如果返回內(nèi)容是scrapy.selector ,如果對象類型是scrapy.selector,那么這個對象可以被繼續(xù)迭代,也可以用xpath繼續(xù)尋找里面的內(nèi)容。

如果終端遇到這個問題:

# ValueError:Missing scheme in request url:h

那么就需要使用extract()將xpath對象轉(zhuǎn)化成列表對象。而列表對象,可以繼續(xù)被迭代,但是不可以使用xpath來尋找里面的對象。

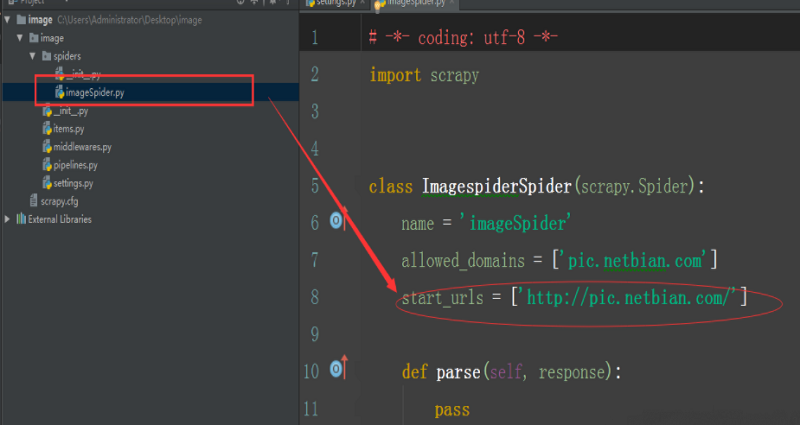

在下載之前還需要在settings.py文件中,對圖片下載的路徑和存儲位置進(jìn)行設(shè)置。

下面附代碼如下。僅有爬蟲文件的代碼:

# -*- coding: utf-8 -*-import scrapyfrom ..items import ImageItemclass ImagespiderSpider(scrapy.Spider): name = 'imageSpider' allowed_domains = ['pic.netbian.com'] start_urls = ['http://pic.netbian.com/4kmeinv/'] def parse(self, response): img_list = response.xpath('//ul[@class="clearfix"]/li/a/img/@src') # 找到了很多src屬性值,現(xiàn)在進(jìn)行遍歷,分別使用每一個 for img in img_list: # 使用在items.py中創(chuàng)建的數(shù)據(jù)模型item item = ImageItem() print('--------------------') img = img.extract() # 拼接圖片的url,得到完整的下載地址 src = 'http://pic.netbian.com' +img # 將得到的數(shù)據(jù)放入到模型中 # 因?yàn)槭窍螺d地址,所以要用列表包起來,否則會報(bào)錯。 item['src'] = [src] yield item next_url = response.xpath('//div[@class="page"]/a[text()="下一頁"]/@href').extract() print('*****************************************************************') if len(next_url)!=0: url = 'http://pic.netbian.com'+next_url[0] # 將url傳給scrapy.Request 得到的結(jié)果繼續(xù)用self.parse進(jìn)行處理 yield scrapy.Request(url=url,callback=self.parse)總結(jié)

以上就是這篇文章的全部內(nèi)容了,希望本文的內(nèi)容對大家的學(xué)習(xí)或者工作具有一定的參考學(xué)習(xí)價值,謝謝大家對VEVB武林網(wǎng)的支持。

新聞熱點(diǎn)

疑難解答

圖片精選